私の連絡先情報

郵便メール:

2024-07-08

한어Русский языкEnglishFrançaisIndonesianSanskrit日本語DeutschPortuguêsΕλληνικάespañolItalianoSuomalainenLatina

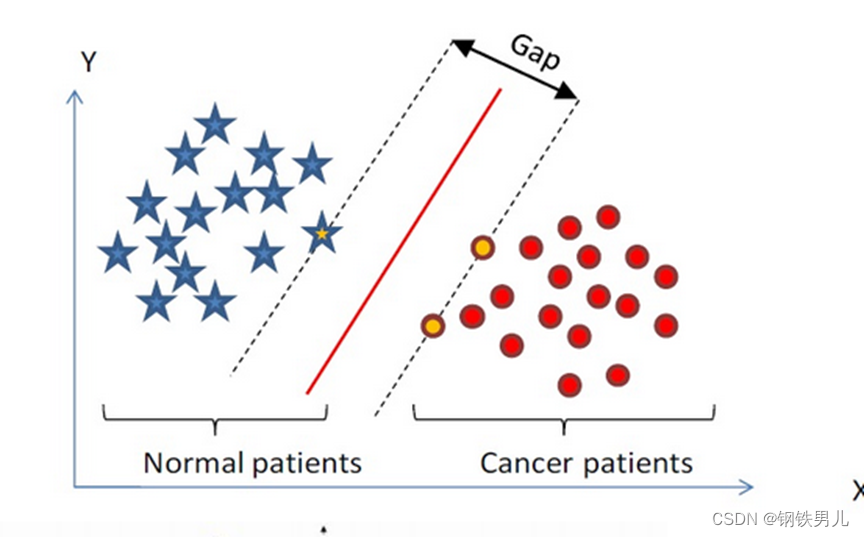

サポート ベクター マシン (SVM) は、1995 年に Corinna Cortes と Vapnik によって最初に提案されました。これは、少量のサンプル、非線形および高次元のパターン認識を解決する際に多くの独自の利点を示します。

n 次元空間で分類超平面を見つけ、その空間内の点をサポート ベクター マシン Supprot Verctor と呼び、中央の赤い線を超平面と呼びます。すべての点と超平面の間の距離を増やします。

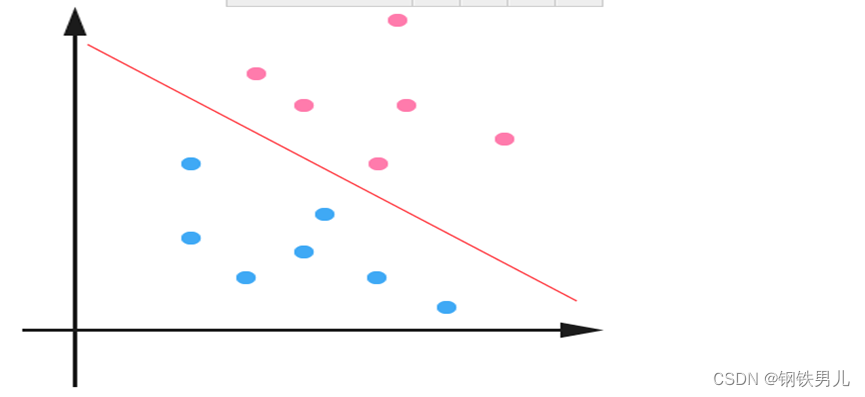

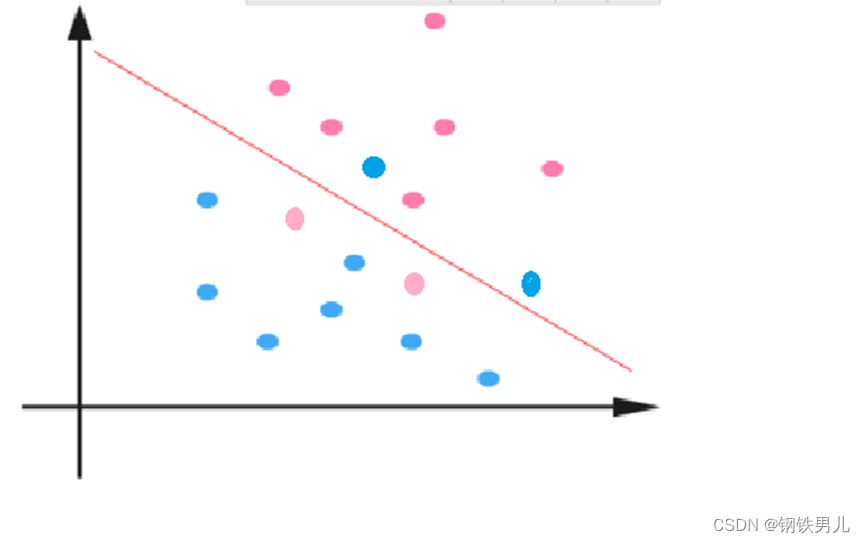

線形分離できない状況の場合、私たちの一般的なアプローチは、サンプルの特徴を高次元空間にマッピングすることです。

ただし、高次元空間にマッピングすると、次元が大きくなりすぎて計算が複雑になる可能性があります。ここでもカーネル関数が導入されています。

カーネル関数: 非線形マッピングとも呼ばれ、サンプルの特徴を高次元空間にマッピングし、この空間内に最適な超平面を構築します。

カーネル関数の種類: 線形カーネル、多項式カーネル、ガウス カーネル (rbf) など。

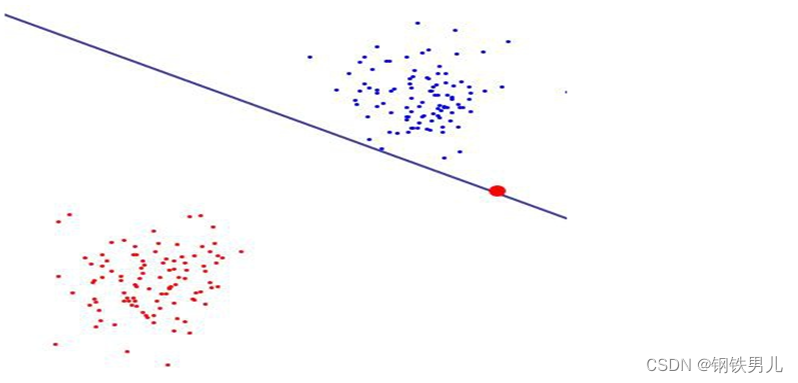

正規定数 C: SVM におけるラグランジュ乗数の制約の程度を指します。

正規定数の値が大きいほど、ペナルティが大きくなり、エラーに対する許容度が低くなり、サポート ベクトルが多くなり、過剰適合につながりやすくなります。

逆に、規則定数が小さいほどアンダーフィッティングが発生しやすくなります。

one-versus-all (one-vers-all 法): トレーニング中に、特定のカテゴリのサンプルが順番に 1 つのカテゴリに分類され、残りの他のサンプルが別のカテゴリに分類されます。このようにして、n 個の SVM が n 個から構築されます。サンプルのカテゴリー。

1 対 1 (1 対 1 法): トレーニング中に、SVM は任意の 2 種類のサンプル間で設計されるため、n (n-1)/2 個の SVM が n カテゴリのサンプルに対して設計される必要があります。

canonical_variates: 線形相関分析では、直線を使用してサンプル点をフィッティングし、n 次元の特徴ベクトル X と出力結果 Y の間の線形関係を見つけます。

主成分分析: 主成分分析 (PCA) は、直交変換を使用して、相関関係のある変数の一連の観測値を、主成分と呼ばれる線形に相関のない変数の値のセットに変換する統計プロセスです。